Co to jest plik Robots.txt w domenie?

Narzędzia Dla Webmasterów Strony Internetowe Seo Bohater / / March 19, 2020

Ostatnia aktualizacja dnia

Jednym z największych błędów dla nowych właścicieli witryn nie jest przeglądanie ich pliku robots.txt. Więc co to jest i dlaczego tak ważne? Mamy twoje odpowiedzi.

Jeśli jesteś właścicielem witryny i zależy Ci na jej SEO zdrowiu, zapoznaj się z plikiem robots.txt w swojej domenie. Wierzcie lub nie, to niepokojąco duża liczba osób, które szybko uruchamiają domenę, instalują szybką stronę WordPress i nigdy nie zawracają sobie głowy robieniem nic z plikiem robots.txt.

To jest niebezpieczne. Źle skonfigurowany plik robots.txt może zniszczyć zdrowie Twojej witryny i zniszczyć wszelkie szanse na zwiększenie ruchu.

Co to jest plik Robots.txt?

The Robots.txt plik ma trafną nazwę, ponieważ jest to zasadniczo plik, który zawiera listę robotów internetowych (takich jak roboty wyszukiwarek), w jaki sposób i w jaki sposób mogą się one indeksować w Twojej witrynie. Jest to standard internetowy, a następnie witryny internetowe od 1994 r. I wszystkie główne roboty indeksujące stosują się do tego standardu.

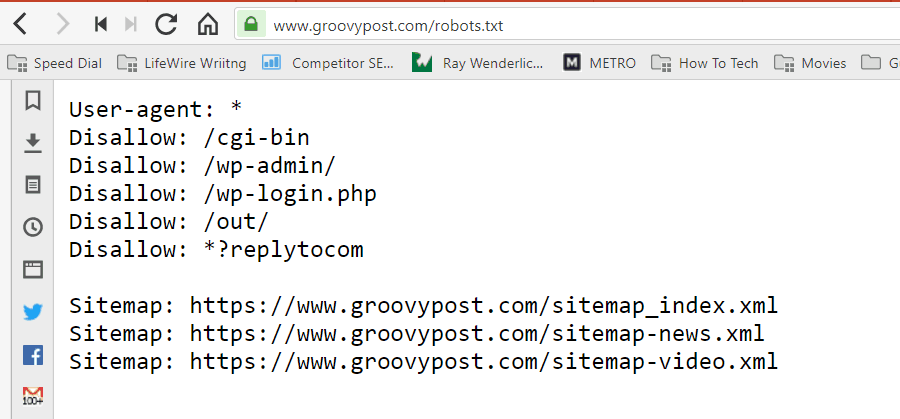

Plik jest przechowywany w formacie tekstowym (z rozszerzeniem .txt) w folderze głównym witryny. W rzeczywistości możesz wyświetlić plik robota.txt dowolnej witryny, wpisując domenę, po której następuje /robots.txt. Jeśli spróbujesz tego z groovyPost, zobaczysz przykład dobrze zorganizowanego pliku robot.txt.

Plik jest prosty, ale skuteczny. Ten przykładowy plik nie rozróżnia robotów. Polecenia są wydawane wszystkim robotom za pomocą Agent użytkownika: * dyrektywa. Oznacza to, że wszystkie następujące po nim polecenia dotyczą wszystkich robotów odwiedzających witrynę w celu jej zaindeksowania.

Określanie przeszukiwaczy sieci

Możesz także określić szczegółowe reguły dla określonych robotów indeksujących. Na przykład możesz zezwolić Googlebotowi (robotowi indeksującemu Google) na indeksowanie wszystkich artykułów w Twojej witrynie, ale możesz chcieć zabrania rosyjskiemu robotowi indeksującemu Yandex Bot indeksowania artykułów w Twojej witrynie, które zawierają dyskredytujące informacje Rosja.

Istnieją setki robotów sieciowych, które przeszukują Internet w poszukiwaniu informacji o witrynach internetowych, ale tutaj wymieniono 10 najczęstszych powinieneś się martwić.

- Googlebot: Wyszukiwarka Google

- Bingbot: Wyszukiwarka Bing firmy Microsoft

- Slurp: Wyszukiwarka Yahoo

- DuckDuckBot: Wyszukiwarka DuckDuckGo

- Baiduspider: Chińska wyszukiwarka Baidu

- YandexBot: Rosyjska wyszukiwarka Yandex

- Exabot: Francuska wyszukiwarka Exalead

- Facebot: Robot indeksujący Facebooka

- ia_archiver: Robot indeksujący w sieci Alexa

- MJ12bot: Baza danych indeksowania dużych łączy

Biorąc przykładowy scenariusz powyżej, jeśli chcesz zezwolić Googlebotowi na indeksowanie wszystkiego w Twojej witrynie, ale chcesz zablokować Yandexowi indeksowanie treści artykułów opartych na języku rosyjskim, dodajesz następujące wiersze do pliku robots.txt plik.

User-agent: googlebot

Disallow: Disallow: / wp-admin /

Disallow: /wp-login.php

Klient użytkownika: yandexbot

Disallow: Disallow: / wp-admin /

Disallow: /wp-login.php

Disallow: / russia /

Jak widać, pierwsza sekcja blokuje Google tylko indeksowanie strony logowania WordPress i stron administracyjnych. Druga sekcja blokuje Yandex od tego samego, ale także z całego obszaru witryny, w którym opublikowałeś artykuły z treścią antyrosyjską.

To jest prosty przykład tego, jak możesz użyć Zakazać polecenie kontrolujące określone roboty indeksujące, które odwiedzają Twoją witrynę.

Inne komendy Robots.txt

Nie zezwalaj nie jest jedynym poleceniem, do którego masz dostęp w pliku robots.txt. Możesz także użyć dowolnego innego polecenia, które pokieruje sposobem, w jaki robot może indeksować Twoją witrynę.

- Zakazać: Informuje klienta użytkownika, aby unikał indeksowania określonych adresów URL lub całych sekcji witryny.

- Dopuszczać: Umożliwia precyzyjne dostrojenie określonych stron lub podfolderów w witrynie, nawet jeśli mógłbyś zabronić dostępu do folderu nadrzędnego. Na przykład możesz zabronić: / about /, ale następnie zezwolić: / about / ryan /.

- Opóźnienie pełzania: Mówi robotowi, aby poczekał xx liczbę sekund przed rozpoczęciem indeksowania treści witryny.

- Mapa strony: Podaj wyszukiwarkom (Google, Ask, Bing i Yahoo) lokalizację swoich map witryn XML.

Pamiętaj, że boty to zrobią tylko słuchaj poleceń podanych podczas określania nazwy bota.

Częstym błędem popełnianym przez użytkowników jest nie zezwalanie na obszary takie jak / wp-admin / ze wszystkich botów, ale następnie określanie sekcji googlebot i nie zezwalanie tylko na inne obszary (takie jak / about /).

Ponieważ boty wykonują tylko polecenia określone w ich sekcji, musisz odtworzyć wszystkie inne polecenia określone dla wszystkich botów (używając * user-agent).

- Zakazać: Komenda używana do poinformowania klienta użytkownika, aby nie indeksował określonego adresu URL. Tylko jeden wiersz „Disallow:” jest dozwolony dla każdego adresu URL.

- Zezwalaj (dotyczy tylko Googlebota): Polecenie poinformowania Googlebota, że może uzyskać dostęp do strony lub podfolderu, nawet jeśli jego strona nadrzędna lub podfolder może być niedozwolona.

- Opóźnienie pełzania: Ile sekund przeszukiwacz powinien czekać przed załadowaniem i przeszukaniem zawartości strony. Pamiętaj, że Googlebot nie potwierdza tego polecenia, ale szybkość indeksowania można ustawić w Google Search Console.

- Mapa strony: Służy do wywoływania lokalizacji map witryn XML powiązanych z tym adresem URL. Uwaga: to polecenie jest obsługiwane tylko przez Google, Ask, Bing i Yahoo.

Pamiętaj, że plik robots.txt ma na celu pomóc legalnym botom (takim jak roboty wyszukiwarek) w skuteczniejszym indeksowaniu witryny.

Istnieje wiele nikczemnych robotów, które indeksują Twoją witrynę w celu zeskrobania adresów e-mail lub kradzieży treści. Jeśli chcesz spróbować użyć pliku robots.txt, aby zablokować robotom indeksującym cokolwiek w Twojej witrynie, nie przejmuj się. Twórcy tych robotów zwykle ignorują wszystko, co umieścisz w pliku robots.txt.

Dlaczego nic nie dopuszczasz?

Sprawienie, by wyszukiwarka Google zaindeksowała jak najwięcej treści wysokiej jakości w Twojej witrynie, jest głównym problemem większości właścicieli witryn.

Jednak Google wydaje tylko ograniczone indeksować budżet i szybkość indeksowania na poszczególnych stronach. Szybkość indeksowania to liczba żądań na sekundę wysyłanych przez Googlebota do Twojej witryny podczas zdarzenia indeksowania.

Ważniejszy jest budżet indeksowania, czyli ile żądań Googlebot wykona, by zaindeksować Twoją witrynę w jednej sesji. Google „wydaje” swój budżet na indeksowanie, koncentrując się na obszarach Twojej witryny, które są bardzo popularne lub ostatnio się zmieniły.

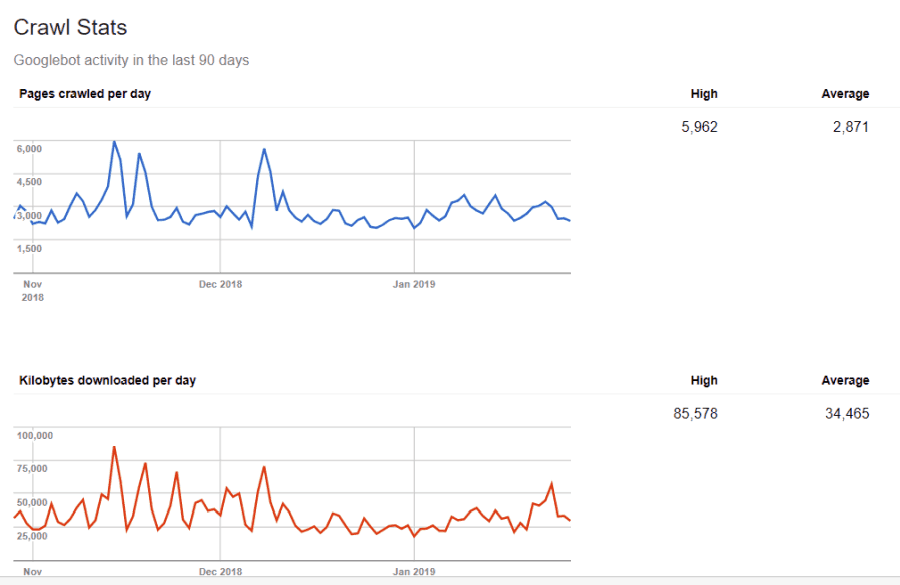

Nie jesteś ślepy na te informacje. Jeśli odwiedzasz Narzędzia Google dla webmasterów, możesz zobaczyć, w jaki sposób robot obsługuje Twoją witrynę.

Jak widać, robot indeksujący codziennie utrzymuje aktywność w witrynie. Nie indeksuje wszystkich witryn, ale tylko te, które uważa za najważniejsze.

Po co pozostawić Googlebotowi decyzję, co jest ważne w Twojej witrynie, kiedy możesz użyć pliku robots.txt, aby powiedzieć mu, jakie są najważniejsze strony? Zapobiegnie to marnowaniu czasu przez Googlebota na stronach o niskiej wartości w Twojej witrynie.

Optymalizacja budżetu indeksowania

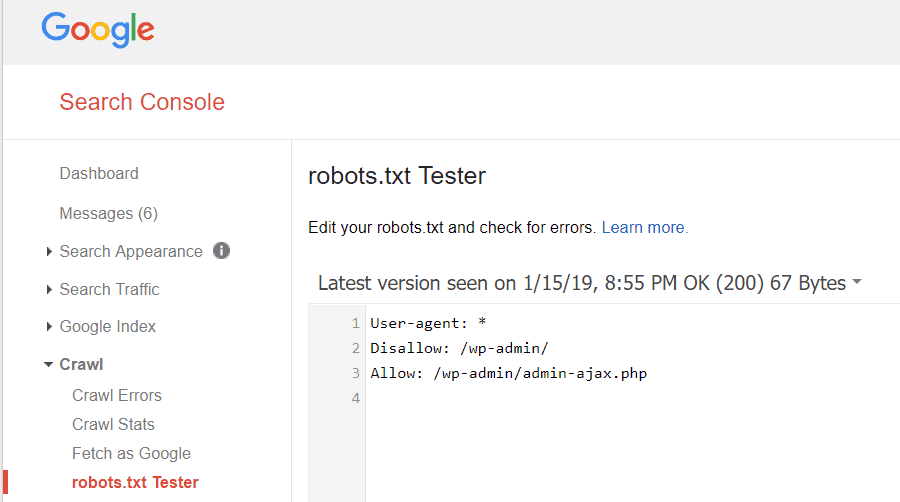

Narzędzia Google dla webmasterów pozwalają również sprawdzić, czy Googlebot dobrze czyta plik robots.txt i czy występują błędy.

Pomoże to zweryfikować poprawność struktury pliku robots.txt.

Jakie strony należy zabronić od Googlebota? SEO Twojej witryny dobrze jest nie zezwalać na następujące kategorie stron.

- Zduplikowane strony (np. Strony przyjazne drukarce)

- Dziękujemy stronom po zamówieniach opartych na formularzu

- Formularze zapytań o zamówienie lub informacje

- Strony kontaktowe

- Strony logowania

- Strony „sprzedaży” z magnesem ołowiowym

Nie ignoruj pliku Robots.txt

Największym błędem, jaki popełniają nowi właściciele witryn, jest to, że nawet nie patrzą na plik robots.txt. Najgorsza sytuacja może być taka, że plik robots.txt faktycznie blokuje twoją witrynę lub obszary witryny w ogóle przed zaindeksowaniem.

Przejrzyj plik robots.txt i upewnij się, że jest zoptymalizowany. W ten sposób Google i inne ważne wyszukiwarki „widzą” wszystkie wspaniałe rzeczy, które oferujesz światu w swojej witrynie.